Wie KI bei der visuellen Suche hilft – von Bildern bis hin zu Videos

Unsere Produkte bei Google haben ein einziges Ziel: Menschen in großen und kleinen Momenten so hilfreich wie möglich zu sein. Und wir glauben seit langem, dass künstliche Intelligenz die Art und Weise, wie wir dieses Ziel erreichen, verbessern kann.

Seit den Anfängen der Suche hat uns KI beim Sprachverständnis geholfen und so die Ergebnisse hilfreicher gemacht. Im Laufe der Jahre haben wir unsere Investitionen in KI vertieft und können nun Informationen in vielen Formen verstehen – vom Sprachverständnis über das Verständnis von Bildern und Videos bis hin zum Verständnis der realen Welt.

Heute teilen wir einige neue Möglichkeiten mit euch, wie wir unsere Fortschritte in der KI anwenden, um das Erkunden von Informationen noch natürlicher und intuitiver zu gestalten.

Suchen, was ihr seht

Kameras bieten eine tolle Möglichkeit, die Welt um uns herum zu erkunden und zu verstehen. Tatsächlich wird Google Lens bereits jetzt schon mehr als 10 Milliarden Mal pro Monat verwendet, wenn Menschen mit ihrer Kamera oder Bildern suchen, was sie sehen.

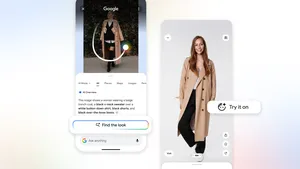

Mit Google Lens möchten wir euch visuell mit den Informationen der Welt verbinden. Nutzer:innen konnten Lens bereits dazu verwenden, um entweder von ihrer Kamera oder bestehenden Bildern aus direkt über die Suchleiste zu suchen. Heute stellen wir ein großes Update vor, das dabei hilft, die Inhalte auf mobilen Bildschirmen zu durchsuchen.

In den kommenden Monaten können Android-Nutzer:innen weltweit mit Lens ihren „Bildschirm durchsuchen“. Mit dieser Technologie können sie auf Webseiten und Apps, wie Messaging- und Video-Apps, suchen, was sie auf Fotos oder Videos sehen – ohne die App verlassen zu müssen.

Mit Google Lens suchen, was auf Fotos oder Videos zu sehen ist und weitere Informationen und ähnliche visuelle Suchergebnisse erhalten.

Angenommen, Freunde senden euch ein Video, in dem sie Paris erkunden. Wenn ihr mehr über das Wahrzeichen erfahren möchtet, das sich im Hintergrund befindet, könnt ihr einfach lange die Ein-/Aus- oder Startbildschirmtaste auf eurem Android-Telefon drücken (was euren Google Assistant aufruft) und dann auf Bildschirmsuche tippen. Google Lens identifiziert das Gebäude als Palais du Luxembourg – und ihr könnt tippen, um mehr über das Wahrzeichen zu erfahren.

Falls ihr in dem Video einen Stuhl bemerkt, der euch gefällt, und ihr herausfinden möchtet, wo es den zu kaufen gibt, dann könnt ihr ebenfalls lange die Ein-/Aus- oder Startbildschirmtaste auf eurem Android-Smartphone halten (was euren Google Assistant aufruft), um dann auf Bildschirmsuche zu tippen und zu den visuellen Ergebnissen zu gelangen.

Suchmöglichkeiten miteinander kombinieren

Mit der Kombi-Suche können Menschen auf eine neue Weise suchen, indem alle Arten von Informationen in der Google Suche miteinander kombiniert werden: Text, Sprache, Bilder und mehr. So können Nutzer:innen hilfreiche Informationen zu allem, was sie sehen, hören und erleben, auf eine intuitive und natürliche Weise finden – sogar bei Fragestellungen, die zuvor nicht möglich waren. Die Kombi-Suche ist ab sofort in den Google-Apps für iOS- und Android-Geräte weltweit in allen Sprachen und Ländern nutzbar, in denen Google Lens verfügbar ist.

Die Kombi-Suche in 5 Schritten

- Um loszulegen, öffnet die Google App und tippt auf das Lens-Symbol in der Suchleiste.

- Mit der Google Lens-Funktion könnt ihr direkt mit eurer Smartphone-Kamera suchen – entweder, indem ihr direkt ein Foto von dem macht, was ihr vor euch seht oder ein bereits bestehendes Bild / Screenshot öffnet.

- Wenn ihr das Bild via Google Lens gemacht oder das Bild / den Screenshot über Google Lens öffnet, habt ihr auch die Möglichkeit, die Suche auf einen bestimmten Ausschnitt einzugrenzen, indem ihr den Suchbereich auf dem Bildschirm markiert oder verschiebt.

- Im nächsten Schritt könnt ihr hochwischen, um zu den Suchergebnissen zu gelangen und mit ihnen zu interagieren.

- Mit der Option „+ Deiner Suche hinzufügen“ könnt ihr in der Suchleiste die Suchanfrage um weitere Details wie Suchbegriffe oder Fragestellungen ergänzen, um die Suche zu verfeinern.

Die Kombi-Suche ist ein hilfreiches Tool, wenn Nutzer:innen sich von etwas inspiriert fühlen – zum Beispiel von einem bestimmten Sessel-Modell, das sie in einem Onlineshop entdeckt haben. Um dasselbe Modell in einer anderen Farbe zu finden, können Nutzer:innen einfach einen Screenshot von dem gelben Sessel machen und dann die Suche via Google Lens in der Google-App um den Suchbegriff „beige“ ergänzen, um Suchergebnisse für dasselbe Modell in beige zu erhalten.

Mit Kombi-Suche „in meiner Nähe“ lokale Informationen finden

Kürzlich haben wir die Kombi-Suche noch weiter ausgebaut, indem wir sie um eine lokale Komponente ergänzt haben. Beispielsweise können Nutzer:innen ein Foto von ihrem Lieblingsessen machen und sich in der Google App via „in meiner Nähe“ lokale Restaurants in der Nachbarschaft anzeigen lassen, die genau dieses Gericht auf der Karte haben. Diese Funktion ist derzeit in den USA auf Englisch verfügbar und wird in den kommenden Monaten weltweit ausgerollt.

Und manchmal seid ihr vielleicht bereits auf der Suche, wenn ihr etwas findet, das euch ins Auge sticht und euch inspiriert. In den nächsten Monaten werdet ihr in der Lage sein, die Kombi-Suche global für jedes Bild zu nutzen, das ihr auf der Suchergebnisseite auf dem Handy seht.

Mit der Kombi-Suche haben Nutzer:innen die Option, ähnliche Couchtischmodelle in einer rechteckigen Variante für ihr Wohnzimmer zu finden.

Zum Beispiel sucht ihr nach „modernen Wohnzimmerideen“ bei Google und entdeckt dabei einen Couchtisch, der euch gefällt. Nur die runde Form sagt euch nicht zu. Ihr könnt die Kombi-Suche verwenden, das Wort „Rechteck“ hinzufügen und so den gesuchten Stil finden.

Wir schaffen damit Sucherlebnisse, die natürlicher und visueller sind – haben damit aber nur an der Oberfläche dessen gekratzt, was möglich ist. Heute könnt ihr das, was ihr seht, mit Hilfe von Google Lens suchen. In Zukunft werden die Möglichkeiten mit Hilfe von KI endlos sein.