TU München und Google forschen zu Cybersicherheit und KI

Wie kann KI genutzt werden, um problematische Inhalte wie Hassrede online zu moderieren? Welche Datenschutzrisiken bestehen bei „General Purpose“ KI-Modellen? Und nach welchen Mustern erfolgen Cyberangriffe auf Large Language Models (LLMs)? Mit diesen und weiteren Fragen beschäftigen sich künftig Forscherinnen und Forscher der Technischen Universität in München (TUM). Durch eine Finanzierung von Google werden an der TUM sieben neue Forschungsprojekte gestartet, die zentrale Aspekte an der Schnittstelle von Cybersecurity und KI untersuchen sollen. Die Arbeit in den sieben Projekten wird von Professor:innen der TUM geleitet und durch deren Teams umgesetzt. Expert:innen von Google stehen jeweils beratend zur Seite.

„KI hat begonnen, unseren Alltag zu durchdringen. Deshalb ist die Weiterentwicklung von KI-Technologien entscheidend. Damit dies gesellschaftlich akzeptabel ist, müssen diese Technologien möglichst zuverlässig und sicher sein. Gemeinsam mit Google treiben wir diese Entwicklungen voran”, so Prof. Thomas F. Hofmann, TUM-Präsident.

Durch die neue Auftragsforschung im Bereich Cybersicherheit und KI vertiefen Google und TUM ihre seit Jahren bestehende Zusammenarbeit am Standort München. 2018 wurde Google als erstes nicht-europäisches Unternehmen Exzellenzpartner der Universität. Seitdem arbeiten Google und TUM unter anderem in den Bereichen Künstliche Intelligenz, Maschinelles Lernen, Computer Vision, Robotik und Quantum Computing zusammen. Darüber hinaus unterstützt Google seit 2022 TUM-Initiativen, die Frauen auf ihrem Karriereweg in den MINT-Fächern Mathematik, Informatik, Naturwissenschaften und Technik fördern. Im Februar 2023 rief die TUM mittels einer nicht zweckgebundenen Spende von Google das TUM Innovation Network zum Thema Cybersecurity ins Leben.

Dr. Wieland Holfelder eröffnet den „Munich Research Day on AI and Cybersecurity" am Münchner Google-Standort

Privacy and (Cyber-)Security – Made in Munich

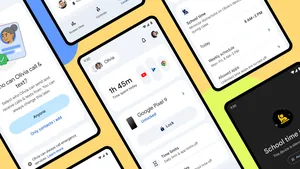

Für Google sind die Themen Datensicherheit und Datenschutz seit vielen Jahren eng mit dem Standort München verbunden. Viele Datenschutzprodukte von Google wurden hier entwickelt, einschließlich des Google-Kontos. Dieses hilft Nutzer:innen dabei, ihre Einstellungen zu Datenschutz und Sicherheit an einem zentralen Ort zu verwalten. Im Google Safety Engineering Center (GSEC), das 2019 eröffnet wurde, arbeiten inzwischen mehr als 300 Ingenieure aus über 40 Nationen an entsprechenden Produkten.

Die Themen Cybersicherheit und Künstliche Intelligenz verschmelzen mehr und mehr miteinander. Wie kann man KI so sicher wie möglich machen? Und wie kann KI helfen, unsere digitale Infrastruktur besser zu schützen? Das sind zentrale Fragen, die wir am Google Safety Engineering Center bearbeiten, und die auch auf der bevorstehenden Münchner Sicherheitskonferenz im Mittelpunkt stehen werden. Wir freuen uns, gemeinsam mit der TUM die Forschung zu diesen Schlüsselthemen weiter voranzubringen.

Marco Lohse, Senior Program Manager Google University Relations beim „Munich Research Day“ mit Student:innen und Expert:innen

Über die sieben Forschungsprojekte

● Sichere Kompilierung leistungsstarker Parallelitätsmodelle (Prof. Pramod Bhatotia): Wie kann gewährleistet werden, dass die für Parallel-Computing-Architekturen angepasste Software sicher ist und keine Schwachstellen aufweist?

● Large Language Models (LLMs) für die Analyse von Programmcode im Hinblick auf Sicherheitsschwachstellen und Datenschutzverletzungen (Prof. Claudia Eckert): Wie können mit neuartigen, LLM-basierten, automatisierten Verfahren Datenschutz- und Sicherheitsschwachstellen in sehr große Codebasen effizienter und präziser ermittelt werden?

● Sondenpositionierung (Prof. Georg Sigl): Hardware kann Informationen preisgeben, die von einer elektromagnetischen Sonde ausgespäht werden können. Die Positionierung der Sonde ist ein offenes Problem. Wie kann KI helfen, Seitenkanalmessungen reproduzierbarer und so die Hardware sicherer zu machen?

● Seitenkanalanalyse der Post-Quantenkryptographie (Prof. Georg Sigl): Wie können automatisch alle Seitenkanallecks der Implementierungen von Quantencomputerresistenter Kryptographie erkannt werden?

● Einstellungen verstehen und Akzeptanz von KI-gestützten Ansätzen zur Inhaltsmoderation fördern (Prof. Jens Großklags): LLMs können zur Automatisierung der Moderation von Inhalten eingesetzt werden, um Hassreden, Sexismus oder Cyber-Mobbing im Internet zu erkennen. Doch wie effektiv sind solche KI-gesteuerten Ansätze und wie werden sie von menschlichen Nutzern wahrgenommen?

● Datenschutzrisiken von allgemeinen KI-Systemen: Stakeholder-Perspektiven in Europa (Prof. Florian Matthes). Welche Datenschutzrisiken bestehen in neuen General-Purpose AI (GPAI)-Systemen wie LLMs? Wie werden diese Risiken im europäischen Raum wahrgenommen?

● Angriffe auf Sprachmodelle verstehen (Prof. Stephan Günnemann): LLMs können angegriffen werden – beispielsweise durch böswillige Aufforderungen, private Benutzerdaten preiszugeben. Wir wollen besser verstehen, wie solche Attacken im Allgemeinen funktionieren, was sie in LLMs auslösen und wie man sie verhindern kann.