Gemini abre un nuevo horizonte: modelos más rápidos, contextos más extensos y agentes de IA

En diciembre, lanzamos nuestro primer modelo multimodal nativo, Gemini 1.0, disponible en tres tamaños: Ultra, Pro y Nano. Pocos meses después, hicimos público 1.5 Pro, con mejoras en el rendimiento y con una ventana de contexto de más de un millón de tokens.

Los desarrolladores y clientes empresariales han usado 1.5 Pro de maneras increíbles y han comprobado que su extensa ventana de contexto, sus funciones de razonamiento multimodal y su impresionante rendimiento a nivel general son tremendamente útiles.

Por los comentarios de los usuarios, sabemos que se necesita menos latencia y un coste de servicio más bajo para algunas aplicaciones. Estas sugerencias nos han motivado para seguir innovando y, por eso, hoy presentamos Gemini 1.5 Flash, un modelo más liviano que el 1.5, diseñado para ser rápido y eficiente para brindar servicio a escala.

Tanto 1.5 Pro como 1.5 Flash están disponibles en prevista pública con una ventana de contexto de un millón de tokens en Vertex AI y en AI Studio. Una ventana de contexto de 2 millones de tokens está disponible para desarrolladores y clientes de Google Cloud a través de la lista de espera. También estamos integrando 1.5 Pro en los productos de Google, incluidos Gemini Advanced y las aplicaciones Workspace.

Además, anunciamos nuestra próxima generación de modelos abiertos, Gemma 2, y compartimos un vistazo del Proyecto Astra, una mirada al futuro de los agentes universales de IA.

Actualizaciones en nuestra familia de modelos Gemini

El nuevo 1.5 Flash: nuestro modelo más rápido y eficiente hasta la fecha

1.5 Flash es el modelo más nuevo de la familia Gemini y el más rápido incluido en la API. Está optimizado para tareas de gran volumen y alta frecuencia a escala y su servicio es más rentable, al mismo tiempo que presenta una innovadora ventana de contexto largo.

Si bien es un modelo más liviano que el 1.5 Pro, es altamente capaz de realizar razonamiento multimodal a través de grandes cantidades de información y ofrece una calidad impresionante para su tamaño.

1.5 Flash sobresale en resúmenes, aplicaciones de chat, subtítulos de imágenes y vídeos, extracción de datos de documentos y tablas extensas, entre otras cosas. Esto se debe a que fue entrenado por 1.5 Pro a través de un proceso llamado "destilación", donde los conocimientos y habilidades más esenciales de un modelo más grande se transfieren a un modelo más pequeño y más eficiente.

Obtén más información sobre 1.5 Flash en nuestro informe técnico actualizado sobre Gemini 1.5, que encontrarás en la página web de Gemini y en el blog de Google for Developers.

Un 1.5 Pro aún más útil

En los últimos meses, hemos mejorado significativamente 1.5 Pro, nuestro mejor modelo para rendimiento general en una amplia gama de tareas. Más allá de ampliar su ventana de contexto a 2 millones de tokens, hemos mejorado su generación de código, razonamiento y planificaciones lógicas, conversación de múltiples turnos y comprensión de audio e imágenes a través de la optimización de algoritmos y datos.

La última versión de 1.5 Pro logra importantes mejoras en los puntos de referencia públicos en varios dominios, como el razonamiento y la codificación, así como un rendimiento de última generación en múltiples puntos de referencia de comprensión de imágenes y vídeos, incluidos: MMMU, AI2D, MathVista, ChartQA, DocVQA, InfographicVQA y EgoSchema.

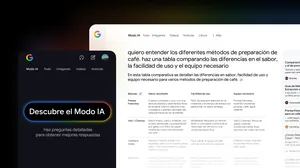

1.5 Pro ahora puede seguir instrucciones cada vez más complejas y concretas, incluidas aquellas que especifican el comportamiento a nivel de producto, como función, formato y estilo. Hemos mejorado el control sobre las respuestas del modelo para casos de uso específicos, como crear la personalidad y el estilo de respuesta de un agente de chat o automatizar flujos de trabajo a través de múltiples llamadas de función. Y hemos permitido a los usuarios controlar el comportamiento del modelo configurando instrucciones del sistema.

También agregamos comprensión de audio en Gemini API y Google AI Studio, por lo que 1.5 Pro ahora puede analizar imágenes y audio para vídeos cargados en Google AI Studio.

Puedes leer más sobre 1.5 Pro en nuestro informe técnico actualizado de Gemini 1.5 y

Actualizaciones de Gemini Nano, nuestro modelo en el dispositivo

Gemini Nano se está expandiendo más allá de las entradas de texto para incluir también imágenes. A partir de Pixel, las aplicaciones que utilicen Gemini Nano con multimodalidad podrán comprender el mundo como lo hacen las personas, no solo mediante la entrada de texto, sino también mediante la vista, el sonido y el lenguaje hablado.

Puedes ampliar información sobre Gemini 1.0 Nano en Android.

La próxima generación de modelos abiertos

Hoy también compartimos una serie de actualizaciones de Gemma, nuestra familia de modelos abiertos creada a partir de la misma investigación y tecnología utilizada para crear los de Gemini.

Anunciamos Gemma 2, nuestra próxima generación de modelos abiertos para la innovación responsable en IA que cuenta con una nueva arquitectura diseñada para lograr un rendimiento y una eficiencia innovadores y estará disponible en nuevos tamaños.

La familia Gemma también se está expandiendo con PaliGemma, nuestro primer modelo de visión y lenguaje inspirado en PaLI-3. Y hemos actualizado nuestro kit de herramientas de IA generativa responsable con LLM Comparator para evaluar la calidad de las respuestas de los modelos.

En el Blog del desarrollador encontrarás más información.

Nuestro progreso en la creación de agentes universales de IA

Para poder hacer realidad la misión de Google Deepmind de crear una IA responsable que beneficie a las personas, desde siempre hemos querido desarrollar un agente de IA universal que pudiera ser útil en situaciones cotidianas.

Para ser útil de verdad, un agente tiene que ser capaz de entender y responder a la compleja y dinámica realidad del mundo igual que lo hacemos las personas. Y, además, asimilar y recordar todo lo que ve y escucha para comprender el contexto y actuar en consecuencia. También tiene que ser proactivo, didáctico y personal, para que los usuarios puedan hablar con él de forma natural, sin retrasos ni esperas.

A pesar de que hemos hecho un progreso increíble en el desarrollo de sistemas de IA capaces de comprender información multimodal, reducir el tiempo de respuesta a un nivel conversacional es un reto de ingeniería complejo. En los últimos años, hemos estado trabajando para mejorar la forma en que nuestros modelos perciben, recuerdan, razonan y conversan para que el ritmo y la calidad de la interacción sean más naturales.

Estos agentes se crearon a partir de nuestro modelo Gemini y otros modelos de tareas específicas. Fueron diseñados para procesar información más rápido, codificando continuamente cuadros de vídeo, combinando la entrada de vídeo y voz en una línea de tiempo de eventos y almacenando en caché esta información para recuperarla de manera eficiente.

Al aprovechar nuestros modelos de habla líderes, también mejoramos su sonido, brindando a los agentes una gama más amplia de entonaciones. Estos agentes pueden comprender mejor el contexto en el que se los utiliza y responder rápidamente en la conversación.

Es fácil imaginar un futuro en el que puedas tener un asistente experto a tu lado a través de tu teléfono o tus gafas. Algunas de estas capacidades llegarán a los productos de Google, como la aplicación Gemini, a finales de este año.

Exploración constante

Hemos logrado avances increíbles hasta ahora con nuestra familia de modelos Gemini y siempre nos esforzamos por hacer avanzar aún más la tecnología punta. Al invertir en una línea de producción incesante de innovación, podemos explorar nuevas ideas en la frontera y, al mismo tiempo, desbloquear la posibilidad de nuevos y emocionantes casos de uso de Gemini.

Puedes ampliar información sobre Gemini y sus capacidades.