Estudio del clima más rápido y preciso con NeuralGCM

Si bien sabemos que nuestro planeta se está calentando de formas sin precedentes, no está del todo claro lo qué esto siginificará para el futuro. ¿Qué partes del mundo enfrentarán sequías prolongadas? ¿Dónde serán más frecuentes las inundaciones costeras a causa de las grandes tormentas tropicales? ¿Cómo cambiarán las temporadas de incendios forestales a medida que aumenten las temperaturas? Para tratar de responder a estas y otras preguntas relacionadas, los científicos necesitan la capacidad de hacer predicciones precisas sobre el clima de la Tierra.

Hoy en el artículo “Modelos de circulación general neuronal para el tiempo y el clima”, publicado en Nature, presentamos NeuralGCM, un nuevo enfoque basado en el aprendizaje automático (ML) para simular la atmósfera terrestre. Desarrollado en colaboración con el Centro Europeo de Pronósticos Meteorológicos a Plazo Medio (ECMWF), NeuralGCM combina el modelado tradicional basado en la física con el ML para mejorar la precisión y la eficiencia de la simulación. Este enfoque genera pronósticos del tiempo de 2 a 15 días que son más precisos que el actual modelo estándar basado en la física, y reproduce las temperaturas de los últimos 40 años con mayor precisión que los modelos atmosféricos tradicionales. Si bien aún no hemos integrado NeuralGCM en un modelo climático completo, representa un paso significativo hacia el desarrollo de modelos climáticos más potentes y accesibles. Esperamos que, eventualmente, permita comprender con mayor precisión y eficacia cómo está cambiando nuestro clima.

Transformando los modelos climáticos

Si bien los modelos climáticos tradicionales han mejorado a lo largo de las décadas, a menudo generan errores y sesgos debido a la comprensión incompleta por parte de los científicos de cómo funciona el clima de la Tierra y cómo se construyen los modelos.

Estos modelos dividen el globo en cubos (generalmente de 50 a 100 KM de lado en el plano horizontal) que se extienden desde la superficie hacia la atmósfera, y luego predicen qué sucede con el clima en cada cubo a lo largo del tiempo. Para hacer predicciones, calculan cómo se mueven el aire y la humedad basándose en leyes físicas bien establecidas. Pero muchos procesos climáticos importantes, incluidas las nubes y la precipitación, varían en escalas mucho más pequeñas (de milímetros a kilómetros) que las dimensiones que el cubo utiliza en los modelos actuales, por lo que no se pueden calcular basándose únicamente en la física. Los científicos tampoco tienen una comprensión física completa de algunos procesos, como la formación de nubes. Por lo tanto, estos modelos tradicionales no se basan solo en principios físicos, sino que utilizan modelos simplificados para generar aproximaciones, llamadas parametrizaciones, para simular los procesos a pequeña escala y menos comprendidos. Estas aproximaciones simplificadas limitan inherentemente la precisión de los modelos climáticos basados en la física.

Al igual que un modelo tradicional, NeuralGCM divide la atmósfera terrestre en cubos y realiza cálculos sobre la física de los procesos a gran escala, como el movimiento del aire y la humedad. Pero, en lugar de depender de las parametrizaciones formuladas por científicos para simular aspectos a pequeña escala como la formación de nubes, utiliza una red neuronal para aprender la física de esos eventos a partir de datos meteorológicos existentes.

Una innovación clave de NeuralGCM es que reescribimos el solucionador numérico para procesos a gran escala desde cero en JAX. Esto nos permitió utilizar la optimización basada en gradiente para ajustar el comportamiento del sistema acoplado “en línea” durante muchos pasos de tiempo. En cambio, los intentos anteriores de mejorar los modelos climáticos con aprendizaje automático tuvieron grandes dificultades con la estabilidad numérica, porque utilizaban entrenamientos “fuera de línea”, que ignoraban la retroalimentación crítica entre procesos a pequeña y gran escala que se acumulan con el tiempo. Otra ventaja de escribir todo el modelo en JAX es que se ejecuta de manera eficiente en TPUs y GPUs, a diferencia de los modelos climáticos tradicionales que funcionan principalmente en CPUs.

Entrenamos un conjunto de modelos NeuralGCM utilizando datos meteorológicos de ECMWF de 1979 a 2019 con resoluciones de 0,7°, 1,4° y 2,8°. Si bien nuestros modelos se entrenaron con pronósticos del tiempo, diseñamos NeuralGCM para que sea un modelo atmosférico de uso general.

Predicciones meteorológicas y climáticas precisas

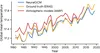

Los modelos recientes de aprendizaje automático (ML) de la atmósfera terrestre, incluido Google DeepMind GraphCast, demostraron una precisión revolucionaria para la predicción del tiempo. La investigación sobre la predicción con ML hasta la fecha se ha centrado principalmente en pronósticos a corto plazo, muy por debajo de los años o décadas necesarios para la proyección climática. Dado que la predicción climática multidecenal es difícil de validar de manera robusta, evaluamos NeuralGCM en predicciones a escala climática y también como modelo meteorológico utilizando la referencia establecida por WeatherBench 2.

El modelo determinista de NeuralGCM a una resolución de 0,7° iguala el rendimiento de los modelos de vanguardia actuales en cuanto a la precisión del pronóstico del tiempo hasta 5 días. Sin embargo, los modelos deterministas carecen de la incertidumbre cuantificada necesaria para realizar pronósticos útiles a plazos más largos. Los conjuntos de pronósticos se generan a partir de condiciones iniciales ligeramente diferentes para producir una gama de escenarios meteorológicos igualmente probables. Al combinarlos estos conjuntos generan predicciones meteorológicas probabilísticas, que, a menudo, son más hábiles que las predicciones deterministas.

El modelo de conjunto de NeuralGCM a una resolución de 1,4° supera a los modelos anteriores de vanguardia en precisión de pronóstico entre 5 y 15 días. El aumento del rendimiento se debe a la capacidad de NeuralGCM de producir pronósticos meteorológicos de conjunto que rivalizan con las del modelo basado en la física de ECMWF, llamado ECMWF-ENS, y NeuralGCM es el primer modelo publicado basado en ML en hacerlo. La precisión del conjunto de NeuralGCM es mejor que la de ECMWF-ENS el 95% de las veces para pronósticos de 2 a 15 días.

NeuralGCM también supera a los modelos atmosféricos de última generación en predicciones a escalas de tiempo climáticas. Debido a que los modelos NeuralGCM solo modelan el componente atmosférico del clima de la Tierra, comparamos su desempeño con modelos basados en la física y solo en la atmósfera. Al predecir las temperaturas durante los 40 años entre 1980 y 2020, el error promedio del modelo determinista de 2.8° de NeuralGCM fue un tercio del de los modelos solo atmosféricos (AMIP) del Proyecto de Intercomparación de Modelos Climáticos: 0,25 frente a 0,75 grados C.

Dado que los modelos atmosféricos tradicionales luchan por simular ciertos aspectos de la atmósfera terrestre, los científicos del clima a veces trabajan con modelos de mayor resolución como X-SHiELD, que son más precisos pero computacionalmente costosos. En comparación con X-SHiELD, el modelo determinista de 1,4° de NeuralGCM tuvo un error entre un 15 y un 50% menor al predecir datos de humedad y temperatura de 2020, el único año de datos proporcionado por investigadores de la Administración Nacional Oceánica y Atmosférica (NOAA). Durante esa simulación climática de 2020, NeuralGCM también predijo patrones de ciclones tropicales que coincidían con el número y la intensidad de las tormentas observadas en las mismas áreas ese año. NeuralGCM es el primer modelo basado en aprendizaje automático capaz de generar dichos patrones.

Un modelo abierto, rápido y eficiente

Desde el punto de vista computacional, NeuralGCM también es más rápido y más barato que los modelos climáticos tradicionales basados en la física. Nuestro modelo de 1,4° es 3.500 veces más rápido que X-SHiELD, lo que significa que si los investigadores simularan la atmósfera durante un año con X-SHiELD, les llevaría 20 días, en comparación con solo 8 minutos con NeuralGCM. Y aunque los científicos solo necesitan una computadora con una TPU para ejecutar NeuralGCM, necesitarían solicitar acceso a una supercomputadora con 13.000 CPUs para ejecutar X-SHiELD. En general, las simulaciones climáticas con NeuralGCM son 100.000 veces menos costosas computacionalmente que con X-SHiELD, una mejora en la velocidad equivalente a 25 años de progreso en la computación de alto rendimiento.

Hemos liberado el código fuente y los pesos del modelo de NeuralGCM en GitHub para uso no comercial. Esperamos que otros investigadores puedan agregar fácilmente nuevos componentes para probar hipótesis y mejorar la funcionalidad del modelo. Además, dado que NeuralGCM puede ejecutarse en una computadora portátil en lugar de requerir acceso a una supercomputadora, esperamos que muchos más investigadores climáticos puedan usar este modelo de última generación en su trabajo.

Direcciones futuras

NeuralGCM actualmente modela solo la atmósfera terrestre. Esperamos incluir en el modelo otros aspectos del sistema climático de la Tierra, como los océanos y el ciclo del carbono. Al hacerlo, permitiremos que NeuralGCM haga predicciones a largo plazo, yendo más allá de predecir el clima durante días y semanas para realizar pronósticos en escalas de tiempo climáticas.

NeuralGCM presenta un nuevo enfoque para construir modelos climáticos que podrían ser más rápidos, menos costosos computacionalmente y más precisos que los modelos existentes.

Agradecimientos

Me gustaría agradecer a los colaboradores del artículo de NeuralGCM de Google, MIT y ECMWF, especialmente al equipo central de NeuralGCM (Dmitrii Kochkov, Janni Yuval, Ian Langmore, Peter Norgaard y Jamie Smith). Gracias también a Michael Torrice, John Guilyard y Elise Kleeman por su ayuda con esta publicación de blog, y a Lizzie Dorfman, Sameera Ponda, Michael Brenner y John Platt por su apoyo y liderazgo.