Quanta energia consuma Google AI? Abbiamo fatto i calcoli

L'AI sta aprendo la strada a scoperte scientifiche, migliorando la sanità e l'istruzione e potrebbe aggiungere migliaia di miliardi di dollari all'economia globale. Comprendere l'impronta ambientale dell'AI è fondamentale, ma i dati approfonditi sull'energia e sull'impatto ambientale dell'inferenza dell'AI, ovvero l'uso di un modello di AI addestrato per fare previsioni o generare testo o immagini, sono ancora limitati. Con l'aumento degli persone che utilizzano i sistemi di AI, cresce l'importanza dell'efficienza dell'inferenza.

Ecco perché abbiamo pubblicato una report tecnico che illustra in dettaglio la metodologia completa che usiamo per misurare l'impatto dei prompt di Gemini in termini di energia, emissioni e acqua. Utilizzando questa metodologia, stimiamo che il prompt di testo mediano 1 di Gemini Apps utilizzi 0,24 wattora (Wh) di energia, emetta 0,03 grammi di equivalente di anidride carbonica (gCO2e) e consumi 0,26 millilitri (circa cinque gocce) di acqua 2 , cifre sostanzialmente inferiori a molte stime pubbliche. L'impatto energetico per prompt è equivalente a guardare la TV per meno di nove secondi.

Allo stesso tempo, i nostri sistemi di AI stanno diventando più efficienti grazie alle innovazioni nella ricerca e ai miglioramenti dell'efficienza del software e dell'hardware. Ad esempio, in un recente periodo di 12 mesi, l'energia e l'impronta di carbonio totale del prompt di testo mediano di Gemini Apps sono diminuite rispettivamente di 33 e 44 volte 3 , il tutto fornendo risposte di qualità superiore. Questi risultati si basano sulle ultime riduzioni delle emissioni energetiche dei nostri data center e sul nostro lavoro per promuovere l'energia a zero emissioni di CO2 e il ripristino delle risorse idriche. Per quanto siamo orgogliosi dell'innovazione alla base dei nostri guadagni di efficienza finora, ci impegniamo a continuare a migliorare in modo sostanziale. Vediamo più da vicino l’impegno in corso.

Il calcolo dell'impronta ambientale dell'AI in Google

La misurazione dettagliata ci consente di confrontare diversi modelli di AI, l'hardware e l'energia su cui vengono eseguiti, consentendo al contempo ottimizzazioni dell'efficienza a livello di sistema, dall'hardware e dai data center ai modelli stessi. Condividendo la nostra metodologia, speriamo di incoraggiare un approccio coerente a livello di settore nel calcolo del consumo di risorse e dell'efficienza dell'AI.

Misurare l'impronta dei carichi di lavoro di distribuzione dell'AI non è semplice. Abbiamo sviluppato un approccio completo che tiene conto delle realtà della fornitura di AI su scala Google, tra cui:

- Potenza dinamica dell'intero sistema: include non solo l'energia e l'acqua utilizzate dal modello di AI principale durante il calcolo attivo, ma anche l'utilizzo effettivo del chip su scala di produzione, che può essere molto inferiore ai massimi teorici.

- Macchine inattive: per garantire alta disponibilità e affidabilità, i sistemi di produzione richiedono un certo grado di capacità di cui è stato eseguito il provisioning, che è inattiva ma pronta a gestire picchi di traffico o failover in qualsiasi momento. L'energia consumata da questi chip inattivi deve essere inclusa nell'impronta energetica totale.

- CPU e RAM: l'esecuzione del modello di AI non avviene solo negli acceleratori ML come TPU e GPU. Anche la CPU e la RAM dell'host svolgono un ruolo cruciale nella gestione dell'AI e consumano energia.

- Overhead del data center: l'energia consumata dalle apparecchiature IT che eseguono carichi di lavoro di AI è solo una parte della storia. Anche l'infrastruttura che supporta questi calcoli (sistemi di raffreddamento, distribuzione dell'energia e altre spese generali del data center) consuma energia. L'efficienza energetica dell'overhead viene misurata da una metrica chiamata Power Usage Effectiveness (PUE).

- Consumo di acqua dei data center: per ridurre il consumo energetico e le emissioni associate, i data center spesso consumano acqua per il raffreddamento. Man mano che ottimizziamo i nostri sistemi di AI per renderli più efficienti dal punto di vista energetico, il loro consumo complessivo di acqua diminuisce naturalmente.

Molti calcoli attuali sul consumo energetico dell'AI includono solo il consumo attivo della macchina, trascurando diversi fattori critici discussi in precedenza. Di conseguenza, rappresentano l'efficienza teorica anziché la vera efficienza operativa su larga scala. Quando applichiamo questa metodologia non esaustiva che considera solo il consumo attivo di TPU e GPU, stimiamo che il prompt di testo mediano di Gemini utilizzi 0,10 Wh di energia, emetta 0,02 gCO2e e consumi 0,12 mL di acqua. Questo è uno scenario ottimistico nella migliore delle ipotesi e sottostima sostanzialmente l'impronta operativa reale dell'AI.

Le stime della nostra metodologia completa (0,24 Wh di energia, 0,03 gCO2e, 0,26 mL di acqua) tengono conto di tutti gli elementi critici della fornitura di AI a livello globale. Riteniamo che questa sia la visione più completa dell'impronta complessiva dell'AI.

Il nostro approccio full-stack all'AI e all'efficienza dell'AI

I notevoli miglioramenti dell'efficienza di Gemini derivano dall'approccio full-stack di Google allo sviluppo dell'AI, dall'hardware personalizzato e dai modelli altamente efficienti ai solidi sistemi di distribuzione che rendono possibili questi modelli. Abbiamo integrato l'efficienza in ogni livello dell'AI, tra cui:

- Architetture di modelli più efficienti: i modelli Gemini sono basati sull'architettura del modello Transformer sviluppata dai ricercatori di Google, che offre un aumento dell'efficienza di 10-100 volte rispetto alle precedenti architetture all'avanguardia per la modellazione del linguaggio. Progettiamo modelli con strutture intrinsecamente efficienti come Mixture-of-Experts (MoE) e ragionamento ibrido. I modelli MoE, ad esempio, ci consentono di attivare un piccolo sottoinsieme di un modello di grandi dimensioni specificamente richiesto per rispondere a una query, riducendo i calcoli e il trasferimento di dati di un fattore 10-100x.

- Algoritmi efficienti e quantizzazione: perfezioniamo continuamente gli algoritmi che alimentano i nostri modelli con metodi come Accurate Quantized Training (AQT) per massimizzare l'efficienza e ridurre il consumo energetico per la distribuzione, senza compromettere la qualità della risposta.

- Inferenza e distribuzione ottimizzate: miglioriamo costantemente la distribuzione dei modelli di AI per garantire reattività ed efficienza. Tecnologie come la decodifica speculativa forniscono più risposte con meno chip consentendo a un modello più piccolo di fare previsioni che vengono poi rapidamente verificate da un modello più grande, il che è più efficiente rispetto al caso in cui il modello più grande fa molte previsioni sequenziali da solo. Tecniche come la distillazione creano modelli più piccoli ed efficienti (Gemini Flash e Flash-Lite) per la distribuzione che utilizzano i nostri modelli più grandi e potenti come insegnanti. Hardware e modelli di machine learning più veloci ci consentono di utilizzare batch di dimensioni maggiori più efficienti durante la gestione delle richieste, pur rispettando i nostri obiettivi di latenza.

- Hardware progettato su misura: progettiamo le nostre TPU da zero da oltre un decennio per massimizzare le prestazioni per watt. Inoltre, progettiamo congiuntamente i nostri modelli di AI e le nostre TPU, assicurandoci che il nostro software sfrutti appieno il nostro hardware e che il nostro hardware sia in grado di eseguire in modo efficiente il nostro futuro software di AI quando entrambi saranno pronti. La nostra TPU di ultima generazione, Ironwood, è 30 volte più efficiente dal punto di vista energetico rispetto alla nostra prima TPU disponibile pubblicamente e molto più efficiente dal punto di vista energetico rispetto alle CPU per uso generico per l'inferenza.

- Inattività ottimizzata: il nostro stack di distribuzione utilizza le CPU in modo altamente efficiente e riduce al minimo l'inattività delle TPU spostando dinamicamente i modelli in base alla domanda in tempo quasi reale, anziché utilizzare un approccio "imposta e dimentica".

- Stack software ML: il nostro compilatore ML XLA, i kernel Pallas e i sistemi Pathways consentono di eseguire in modo efficiente i calcoli del modello espressi in sistemi di livello superiore come JAX sull'hardware di distribuzione TPU.

- Data center ultra efficienti: i data center di Google sono tra i più efficienti del settore, con un PUE medio a livello di flotta pari a 1,09.

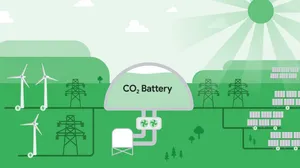

- Gestione responsabile dei data center: continuiamo ad aggiungere produzione di energia pulita per perseguire la nostra ambizione di energia priva di carbonio 24 ore su 24, 7 giorni su 7, mentre avanziamo verso il nostro obiettivo di reintegrare il 120% dell'acqua dolce che consumiamo in media nei nostri uffici e data center. Ottimizziamo anche i nostri sistemi di raffreddamento, bilanciando il compromesso locale tra energia, acqua ed emissioni, conducendo valutazioni scientifiche sulla salute dei bacini idrografici per guidare la selezione del tipo di raffreddamento e limitare l'uso dell'acqua in luoghi ad alto stress idrico.

Il nostro impegno per un'AI efficiente

I miglioramenti dell'efficienza di Gemini sono il risultato di anni di lavoro, ma questo è solo l'inizio. Riconoscendo che la domanda di AI è in crescita, stiamo investendo molto nella riduzione dei costi di fornitura di energia e dell'acqua necessaria per prompt. Condividendo i nostri risultati e la nostra metodologia, puntiamo a promuovere il progresso a livello di settore verso un'AI più efficiente. È essenziale per lo sviluppo responsabile dell'AI.