Google I/O 2023: Sprawiamy, że sztuczna inteligencja staje się bardziej pomocna dla wszystkich

Notka redakcyjna: Oto podsumowanie ogłoszeń z konferencji Google I/O 2023. Wszystkie artykuły znajdziecie w naszej kolekcji.

Po siedmiu latach drogi do umieszczenia AI w centrum działań naszej firmy znaleźliśmy się w punkcie zwrotnym. Mamy szansę sprawić, aby sztuczna inteligencja była jeszcze bardziej przydatna dla ludzi, przedsiębiorstw, społeczności – po prostu dla wszystkich.

Już od jakiegoś czasu wykorzystujemy AI do ulepszania naszych produktów i usług. Wprowadzenie generatywnej sztucznej inteligencji to kolejny krok. Z jej wykorzystaniem na nowo tworzymy najważniejsze usługi, włącznie z wyszukiwarką, stosując przy tym odważne, ale jednocześnie odpowiedzialne podejście.

Funkcja „Pomóż mi w pisaniu” w Gmailu

Mamy już świetne przykłady tego, jak generatywna AI pomaga nam rozwijać usługi. Zacznijmy od Gmaila. W 2017 roku wprowadziliśmy Inteligentną odpowiedź, czyli krótkie propozycje odpowiedzi, które można wybrać jednym kliknięciem. Następnie pojawiło się Inteligentne tworzenie wiadomości, które wyświetla sugestie podczas pisania tekstu e-maila. Kolejnym krokiem było wprowadzenie bardziej zaawansowanych funkcji pisania wspomaganych przez sztuczną inteligencję, z których użytkownicy i użytkowniczki Workspace skorzystali w samym zeszłym roku ponad 180 miliardów razy.

A teraz, dzięki znacznie potężniejszemu modelowi generatywnemu, wprowadzamy w Gmailu kolejną rewolucję – funkcję Pomóż mi w pisaniu.

Wyobraźcie sobie, że otrzymujecie e-maila z informacją, że Wasz lot został odwołany. Linie lotnicze w ramach rekompensaty wysłały Wam kupon, ale wolicie pełny zwrot pieniędzy. Możecie odpowiedzieć na maila, korzystając z funkcji Pomóż mi w pisaniu.

Wystarczy, że wpiszecie prompta z instrukcją – np. „napisz wiadomość z prośbą o pełny zwrot kosztów” – i klikniecie Utwórz, a pojawi się wersja robocza e-maila. Wszystkie potrzebne dane lotu zostaną pobrane z poprzedniej wiadomości. E-mail wygląda całkiem dobrze, ale być może chcecie go jeszcze dopracować. W końcu bardziej rozbudowana wiadomość może zwiększyć szanse na uzyskanie zwrotu. Funkcję Pomóż mi w pisaniu wprowadzimy w ramach naszych aktualizacji Google Workspace. Podobnie jak w przypadku Inteligentnego tworzenia wiadomości z czasem zauważycie, że działa ona coraz lepiej.

Nowa funkcja Immersive View dla tras w Mapach

Od początku istnienia Street View AI łączyła miliardy panoramicznych zdjęć, aby użytkownicy mogli odkrywać świat bez wychodzenia z domu. Podczas ubiegłorocznej konferencji I/O zaprezentowaliśmy funkcję Immersive View, która wykorzystuje sztuczną inteligencję do tworzenia wysokiej jakości modelu danego miejsca, aby można było je dokładnie obejrzeć jeszcze przed wizytą na żywo.

Teraz wykorzystujemy tę samą technologię do tego, w czym Mapy są najlepsze, czyli do pomagania użytkownikom w dotarciu do celu. Mapy Google codziennie generują wskazówki dojazdu dla tras o łącznej długości 20 miliardów kilometrów – to całkiem sporo. Teraz wyobraź sobie, że możesz zobaczyć całą swoją trasę z wyprzedzeniem. Z funkcją Immersive View dla tras jest to teraz możliwe niezależnie od tego, jak podróżujesz – pieszo, na rowerze czy samochodem.

Powiedzmy, że jesteś w Nowym Jorku i chcesz wybrać się na przejażdżkę rowerem. Mapy zasugerowały Ci kilka opcji w pobliżu miejsca, w którym się znajdujesz. Trasa przy nabrzeżu wygląda malowniczo, ale chcesz najpierw poczuć jej klimat, więc klikasz Immersive View dla tras. To zupełnie nowy sposób patrzenia na podróż. Możesz przybliżyć obraz, aby zobaczyć niesamowity widok trasy z lotu ptaka.

Dostępne są również dodatkowe informacje. Możesz sprawdzić jakość powietrza, ruch drogowy i pogodę oraz zobaczyć, jak mogą się one zmieniać w trakcie przejazdu.

Immersive View dla tras zaczniemy wprowadzać latem, a do końca roku planujemy udostępnić tę funkcję w 15 miastach, m.in. w Londynie, Nowym Jorku, Tokio i San Francisco.

Nowe funkcje Magicznej edycji w Zdjęciach Google

Zdjęcia Google to kolejna usługa, którą ulepszyliśmy dzięki sztucznej inteligencji. Zaprezentowaliśmy ją na konferencji I/O w 2015 roku i była jednym z naszych pierwszych rozwiązań od początku tworzonych w oparciu o AI. Wtedy przełom w technologii systemów uczących się umożliwił przeszukiwanie zdjęć pod kątem takich elementów jak np. twarze, zachody słońca czy wodospady.

Oczywiście chcemy, aby można było robić znacznie więcej niż tylko przeszukiwać zdjęcia – chcemy pomóc je ulepszać. Każdego miesiąca użytkownicy Zdjęć Google edytują aż 1,7 miliarda obrazów, a postępy w dziedzinie AI umożliwiają nam tworzenie narzędzi, które im w tym pomagają. Na przykład magiczna gumka, wprowadzona początkowo na urządzeniach Pixel, wykorzystuje napędzaną przez AI fotografię obliczeniową, aby usuwać niechciane elementy ze zdjęcia. Jeszcze w tym roku udostępnimy nowy zestaw funkcji zwany Magiczną edycją, który dzięki połączeniu semantycznego rozumienia i generatywnej AI pozwoli ulepszać zdjęcia na nowe sposoby.

Oto przykład: To jest świetne zdjęcie, ale jako rodzic prawdopodobnie chcesz, aby Twoje dziecko było w centrum kadru. W dodatku balony nie są widoczne w całości. Jeśli postanowisz przenieść solenizanta na środek, funkcja Magicznej edycji automatycznie wygeneruje fragmenty ławki i balonów, które nie zostały uwiecznione na pierwotnym zdjęciu. Na koniec możesz dodatkowo wzmocnić kolor nieba. Spowoduje to również zmiany w oświetleniu reszty zdjęcia, aby edycja była spójna. To naprawdę magiczne. Nie możemy doczekać się wprowadzenia Magicznej edycji w Zdjęciach Google jeszcze w tym roku.

Zdjęcia małego chłopca siedzącego na ławce na dachu z widokiem na miasto i trzymającego w ręku kolorowe balony. Na zdjęciu po prawej stronie chłopiec znajduje się w centrum kadru, widać więcej ławki i balonów, a niebo jest mniej zachmurzone.

Udostępniamy moc AI wszystkim użytkownikom

Od Gmaila przez Zdjęcia po Mapy – to tylko kilka przykładów, jak sztuczna inteligencja może nam pomagać w istotnych momentach. A to dopiero początek. Mamy jeszcze mnóstwo pomysłów, jak wykorzystać pełny potencjał AI we wszystkich usługach, które znacie i lubicie.

Obecnie oferujemy 15 usług, a z każdej z nich korzysta ponad pół miliarda użytkowników i firm. Sześć z nich ma ponad 2 miliardy użytkowników. To daje nam niesamowitą możliwość realizacji naszej misji, którą jest uporządkowanie światowych zasobów informacji tak, by stały się powszechnie dostępne i użyteczne dla każdego.

To misja ponadczasowa, która z biegiem lat nabiera coraz większego znaczenia. Patrząc w przyszłość, widzimy, że zadbanie o to, aby sztuczna inteligencja była przydatna dla wszystkich, jest najlepszym sposobem na dalszą realizację tej misji. A realizujemy ją na cztery sposoby:

- Po pierwsze, poprzez rozwijanie i pogłębianie Waszej wiedzy o świecie.

- Po drugie, poprzez zwiększenie kreatywności i produktywności, abyście mogli lepiej wyrażać siebie i osiągać cele.

- Po trzecie, poprzez ułatwianie programistom i firmom tworzenia własnych przełomowych produktów i usług.

- I po czwarte, poprzez budowanie i wdrażanie sztucznej inteligencji w sposób odpowiedzialny, aby każdy mógł w równym stopniu korzystać z jej zalet.

PaLM 2 i Gemini

Jesteśmy bardzo podekscytowani stojącymi przed nami możliwościami. Zwiększanie przydatności sztucznej inteligencji jest możliwe tylko dzięki nieustannemu doskonaleniu podstawowych modeli. Chciałbym teraz podzielić się z Wami tym, w jaki sposób je rozwijamy.

W ubiegłym roku wspominaliśmy o modelu PaLM, który umożliwił wprowadzenie wielu ulepszeń w naszych usługach. Dzisiaj ogłaszamy nasz najnowszy model PaLM, który jest już w produkcji: PaLM 2. PaLM 2 opiera się na badaniach podstawowych i wykorzystuje najnowocześniejszą infrastrukturę. Świetnie radzi sobie z szerokim zakresem zadań i jest łatwy we wdrożeniu. Dzisiaj prezentujemy ponad 25 usług i funkcji, których działanie opiera się na modelu PaLM 2.

Modele PaLM 2 zapewniają doskonałe funkcje podstawowe i są dostępne w różnych rozmiarach. Nadaliśmy im sympatyczne nazwy: Gecko, Otter, Bison i Unicorn. Gecko jest tak lekki, że może działać na urządzeniach mobilnych, a jednocześnie wystarczająco szybki, aby można go było wykorzystać w interaktywnych aplikacjach na urządzeniu (nawet bez połączenia z siecią). Modele PaLM 2 były trenowane na zagadnieniach z dziedziny matematyki i nauki, dzięki czemu wykazują się bardziej zaawansowanymi umiejętnościami myślenia logicznego i wyciągania wniosków. Do trenowania modelu wykorzystaliśmy też wielojęzyczny zbiór danych obejmujący ponad 100 języków, co sprawia, że PaLM 2 potrafi zrozumieć i wygenerować złożony tekst.

Dzięki zaawansowanym umiejętnościom programistycznym PaLM 2 może również pomagać deweloperom z całego świata. Wyobraź sobie, że współpracujesz z kolegą z Seulu przy debugowaniu kodu. Możesz poprosić PaLM 2 o naprawienie błędu i dodanie do kodu komentarzy w języku koreańskim, które ułatwią pracę Twojemu koledze. Model rozpoznaje rekurencję w kodzie, a następnie sugeruje, jak ją naprawić. Dodaje też uzasadnienie poprawki i komentarze po koreańsku, zgodnie z Twoją prośbą.

PaLM 2 oferuje niesamowite możliwości, ale największe wrażenie robi, gdy zostanie wytrenowany pod kątem wiedzy z konkretnej dziedziny. Ostatnio wprowadziliśmy Sec-PaLM – model wytrenowany w dziedzinie zabezpieczeń. Wykorzystuje on sztuczną inteligencję do skuteczniejszego wykrywania złośliwych skryptów i może pomóc ekspertom ds. bezpieczeństwa w znajdowaniu zagrożeń i im zapobieganiu.

Kolejnym przykładem jest Med-PaLM 2. Ten model został wytrenowany na wiedzy medycznej i w porównaniu do modelu bazowego popełnia dziewięciokrotnie mniej pomyłek we wnioskowaniu, uzyskując wyniki bliskie tym osiąganym przez ekspertów klinicznych, którzy odpowiedzieli na ten sam zestaw pytań. Med-PaLM 2 to pierwszy model językowy, który osiągnął poziom ekspercki w odpowiedziach na pytania wzorowane na egzaminie lekarskim.

Pracujemy również nad dodaniem do Med-PaLM 2 możliwości wyciągania wniosków na podstawie zdjęć z urządzeń do obrazowania medycznego, takich jak aparaty rentgenowskie czy mammograficzne. Można sobie wyobrazić współpracownika w postaci AI, który pomaga radiologom interpretować zdjęcia i przekazywać wyniki. To tylko kilka przykładów wykorzystania PaLM 2 do specjalistycznych zastosowań. Jesteśmy bardzo ciekawi, co jeszcze można z nim zrobić, dlatego z przyjemnością ogłaszam, że od dziś PaLM 2 jest dostępny w wersji testowej.

PaLM 2 to najnowszy krok w naszej trwającej od dekady misji udostępniania AI w sposób odpowiedzialny miliardom ludzi. Model opiera się na postępach osiągniętych przez dwa światowej klasy zespoły badawcze: Brain Team i DeepMind.

Członkowie tych zespołów mieli swój udział w wielu przełomach w dziedzinie AI, które nastąpiły w ciągu ostatniej dekady, takich jak AlphaGo, transformery, modele sekwencyjne itd. Wszystko to doprowadziło nas do punktu zwrotnego, w którym się obecnie znajdujemy.

Ostatnio połączyliśmy te dwa zespoły w jedną jednostkę - Google DeepMind - która wykorzystuje zasoby obliczeniowe Google do tworzenia jeszcze potężniejszych systemów w sposób bezpieczny i odpowiedzialny.

W ramach tego procesu tworzymy nasz model podstawowy nowej generacji – Gemini – który nadal jest w fazie trenowania. Gemini został od podstaw stworzony z myślą o multimodalności, wydajności w zakresie integracji z narzędziami i interfejsami API oraz umożliwieniu przyszłych innowacji związanych m.in. z pamięcią i planowaniem. Mimo że model jest wciąż na wczesnym etapie rozwoju, już teraz obserwujemy imponujące zdolności multimodalne, których brakowało poprzednim modelom.

Po wytrenowaniu pod kątem specjalistycznej wiedzy i przeprowadzeniu rygorystycznych testów bezpieczeństwa, udostępnimy model Gemini w różnych rozmiarach i wariantach, podobnie jak w przypadku PaLM 2.

Odpowiedzialność za AI: narzędzia do identyfikacji wygenerowanych treści

Rozwijając modele o coraz większych możliwościach, jednocześnie dbamy o stosowanie odpowiedzialnego podejścia do AI. Obejmuje to narzędzia, które wykrywają syntetycznie wygenerowane treści.

Dwa ważne rozwiązania to znakowanie wodne i metadane. Znakowanie wodne umieszcza informacje bezpośrednio w treści w taki sposób, że nie są one usuwane nawet przy niewielkiej edycji obrazu. Od teraz zamierzamy tworzyć tylko modele z domyślnie wbudowanym znakowaniem wodnym i innymi technikami ułatwiającymi identyfikację treści.

Syntetycznie wygenerowane obrazy już teraz wyglądają bardzo realistycznie, więc można sobie wyobrazić, jak ważne takie znakowanie będzie w przyszłości. Metadane pozwalają twórcom treści powiązać dodatkowy kontekst z oryginalnymi plikami, aby w ten sposób dostarczać więcej informacji użytkownikom mającym styczność z treścią. Zadbamy o to, aby każdy obraz wygenerowany przez nasze usługi oparte na AI zawierał takie metadane. Więcej informacji na temat odważnego i odpowiedzialnego podejścia znajdziesz tutaj.

Aktualizacje Barda i Google Workspace

W miarę jak modele stają się coraz bardziej zaawansowane, jednym z najbardziej ekscytujących kolejnych kroków jest udostępnianie ich bezpośrednio użytkownikom.

Taką możliwość daje nam Bard, nasza eksperymentalna konwersacyjna sztuczna inteligencja, którą uruchomiliśmy w marcu. Bard szybko się rozwija – obecnie może pochwalić się szerokimi umiejętnościami programistycznymi, sprawniejszym wyciąganiem wniosków i lepszymi zdolnościami matematycznymi. Od dzisiaj działa w pełni na modelu PaLM 2. Więcej informacji o najnowszych aktualizacjach Barda znajdziesz tutaj.

Udostępniamy również nowe funkcje w Google Workspace. Oprócz funkcji „Pomóż mi w pisaniu” dostępnej w Dokumentach i Gmailu, Duet AI w Google Workspace dostarcza narzędzia do generowania obrazów na podstawie opisów tekstowych w Prezentacjach i Meet; możliwość tworzenia niestandardowych planów w Arkuszach oraz wiele innych przydatnych funkcji. Więcej informacji o najnowszych aktualizacjach Google Workspace znajdziesz tutaj.

Przedstawiamy Laboratoria i nowe funkcje generatywne w wyszukiwarce

Wraz z szybkim rozwojem sztucznej inteligencji skupiamy się na dostarczaniu użytkownikom przydatnych funkcji. A dziś udostępniamy nową metodę na poznawanie niektórych funkcji Google Workspace i innych usług, czyli Laboratoria. Mówię, że to nowość, ale tak naprawdę Google od dawna korzysta z Laboratoriów jako sposobu na zapewnienie użytkownikom wczesnego dostępu do nowych funkcji i zbieranie ich opinii. Rejestracja jest możliwa już dziś.

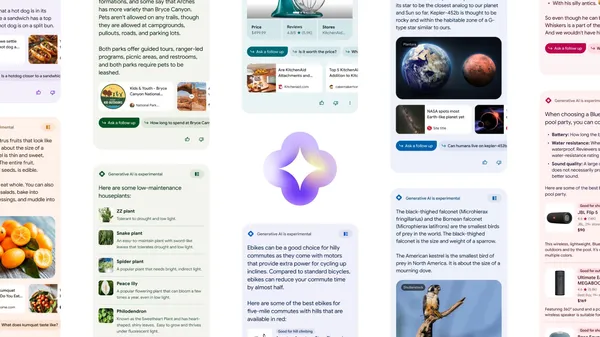

Oprócz funkcji Google Workspace, które dziś zaprezentowaliśmy, w Laboratoriach będzie można przetestować nową funkcję naszej pierwszej i najważniejszej usługi – wyszukiwarki Google. To właśnie możliwość usprawnienia wyszukiwarki przekonała nas wiele lat temu do inwestycji w AI - a z każdą przełomową zmianą ta usługa stawała się jeszcze bardziej pomocna i intuicyjna.

Postępy w rozumieniu języka pozwalają nam zadawać pytania w bardziej naturalny sposób i docierać do najbardziej istotnych treści w sieci. Ulepszenia w dziedzinie rozpoznawania obrazów zapewniły nam nowe możliwości wyszukiwania wizualnego. Dziś nawet jeśli nie potrafisz opisać tego, czego szukasz, możesz skorzystać z Obiektywu Google. Obecnie użytkownicy korzystają z wyszukiwania przez Obiektyw Google 12 miliardów razy miesięcznie – to czterokrotny wzrost w ciągu zaledwie dwóch lat. Obiektyw w połączeniu z multimodalnością dał początek multiwyszukiwaniu, które umożliwia szukanie za pomocą zarówno obrazu, jak i tekstu.

W przyszłości głębokie zrozumienie informacji przez Google w połączeniu z unikalnymi możliwościami generatywnej sztucznej inteligencji może doprowadzić do kolejnej rewolucji w działaniu wyszukiwarki. Umożliwi znalezienie odpowiedzi na zupełnie nowe pytania i przyczyni się do stworzenia jeszcze bardziej przydatnych funkcji pozwalających wykorzystać bogactwo informacji dostępnych w sieci.

Oczywiście wykorzystanie generatywnej AI w wyszukiwarce jest wciąż na wczesnym etapie. Użytkownicy z całego świata polegają na wyszukiwarce w kluczowych momentach, a my wiemy, jak ważne jest, aby uzyskiwane przez nich odpowiedzi były przydatne i budowały zaufanie. To zawsze było, jest i będzie naszym priorytetem.

Dlatego podchodzimy do innowacji w sposób odpowiedzialny, dążąc do osiągnięcia najwyższych standardów jakości informacji, tak jak to robiliśmy od samego początku. To właśnie z tego powodu nowe funkcje generatywne wyszukiwarki w pierwszej kolejności udostępniamy w Laboratoriach.

Ułatwiamy innym wprowadzanie innowacji

Sztuczna inteligencja to nie tylko potężne narzędzie, ale także duża zmiana platformowa. Każda firma i organizacja zastanawia się nad tym, jak przeprowadzić tę transformację. Dlatego staramy się ułatwić im wprowadzanie innowacji z wykorzystaniem AI w sposób skalowalny.

Oznacza to dostarczanie najbardziej zaawansowanej infrastruktury obliczeniowej – w tym najnowocześniejszych jednostek TPU i GPU – oraz udostępnianie najnowszych modeli podstawowych Google, które zostały rygorystycznie przetestowane w naszych własnych usługach. Pracujemy również nad dostarczaniem narzędzi na światowym poziomie, dzięki którym klienci będą mogli trenować, dostosowywać i uruchamiać własne modele, zachowując jednocześnie wysoki poziom bezpieczeństwa, ochrony i prywatności na poziomie przedsiębiorstwa. Więcej informacji można znaleźć w wypowiedzi prezesa Google Cloud, Thomasa Kuriana.

Postęp napędzany przez Androida

Nasze odważne i odpowiedzialne podejście do sztucznej inteligencji pomaga ludziom w wykorzystaniu własnego potencjału twórczego. Jednocześnie chcemy, aby z tych nowych możliwości mogło korzystać jak najwięcej osób. Udostępniamy je m.in. za pomocą naszych platform obliczeniowych, takich jak Android. Dziś pokazaliśmy, w jaki sposób funkcje oparte na AI – takie jak magiczne komponowanie, tapety filmowe i tapety wykorzystujące generatywną AI – mogą sprawić, że nasze telefony będą jeszcze bardziej spersonalizowane.

Prezentujemy nowe urządzenia Pixel do kieszeni i do domu

Przedstawiamy Pixel 7a, Pixel Fold i Pixel Tablet – stworzony przez Google kompletny ekosystem urządzeń opartych na AI. Pixel 7a jest dostępny w sprzedaży od dziś, a urządzenia Pixel Fold i Pixel Tablet są dostępne w przedsprzedaży.

Wspólnie budujemy przyszłość

Zastanawiam się nad dużymi zmianami technologicznymi, w których uczestniczyliśmy do tej pory. Zmiana związana z AI jest największa, dlatego tak bardzo nam zależy, aby ta technologia stała się przydatna dla wszystkich.

Podchodzimy do tego wyzwania z odwagą i entuzjazmem, a jednocześnie działamy odpowiedzialnie, ponieważ chcemy wprowadzać AI we właściwy sposób.

Żadna firma nie jest w stanie tego osiągnąć sama. Nasza społeczność programistów i programistek odegra kluczową rolę w wykorzystaniu ogromnych możliwości, które są przed nami. Nie możemy się doczekać wspólnego budowania przyszłości.